-

近年来,高光谱图像分类技术受到了普遍关注,在很多不同的领域中发挥作用。目前该技术已广泛用于国防、农业、地质、环境、海洋勘探和其它领域[1]。与多光谱图像相比,高光谱图像不仅具有丰富的特征信息,而且具有多波段和高数据维度的特征,这也导致高光谱图像分类难以实现高分类精度[2]。高光谱自身特性和外在的影响又增加了对高光谱图像分类的困难,使得高光谱图像分类任务更加艰巨。因此,研究一个有效提升高光谱图像分类性能的方法模型具有极其重要的实际价值。

在高光谱图像分类领域,一些学者提出了许多方法和模型,典型的是深度学习方法,它能够提取鲁棒特征,相比于其它方法具有明显的性能优势[3]。深度学习方法被应用在高光谱遥感分类领域中并取得了一定效果[4]。随后,逐渐出现了其它的深度学习模型,并被引入到遥感图像分类中。主要有稀疏自动编码器[5]、深度信念网络[6]和卷积神经网络(convolutional neural network, CNN)[7]等。然而,在空间特征提取阶段,深度信念网络和稀疏编码器网络两个模型要求将输入图像块展平为1维向量,这会忽略原始图像中的空间结构信息,造成空间特征丢失的问题[8]。CNN在图像分类领域具有极其重要的价值,并且在图像分类领域表现出显著性能[9]。ZHANG等人[10]提出了基于1维卷积、2维卷积(two-dimensional convolutional neural network, 2D-CNN)的光谱空间双通道网络架构。ZHAO等人[3]提出了一种基于CNN和降维技术的光谱-空间分类方法,然后通过归一化指数函数(softmax)回归分类器将其组合在一起。但是参考文献[3]和参考文献[10]中并没有充分利用联合光谱-空间相关信息。同样, XU等人[8]提出了一种光谱-空间特征统一的网络模型结构(spectral-spatial unified networks, SSUN), 该结构中使用2D-CNN和长短期记忆分别用于提取空间特征和光谱特征, 但这项工作需要对原始高光谱数据进行一系列预处理以满足不同的输入要求, 且模型结构较复杂。ZHONG等人[11]提出了一种基于光谱空间信息的残差结构, 它将原始高光谱图像的3维块作为输入数据来学习空间和光谱特征信息, 采用残差块来改善梯度的反向传播, 并使用批量正则化来规范模型的学习过程, 但是它需要大量的标记数据来微调影响其泛化能力的训练参数, 同时也存在梯度消失导致的信息丢失现象。此外, LI等人[12]提出了混合CNN, 它将1维、2维和3维卷积网络(three-dimensional convolutional neural network, 3D-CNN)分别作为3个特征提取分支, 但是该工作中采用的是最后一层神经网络的输出来提取空间特征, 不足以捕捉细粒度的空间细节。

针对以上的研究, 作者设计了混合CNN的高光谱图像分类(hybrid convolutional neural network, HYCNN)方法。将2D-CNN和3D-CNN结合充分利用光谱-空间特征信息, 并使用空间增强分支来提高空间信息的利用率。同时使用多尺度融合策略将浅层特征和深层特征进行融合, 缓解了神经网络在池化过程中特征信息丢失的现象, 保证了提取信息的完整性, 进而改善分类效果。最后, 通过softmax训练分类器得到最终结果。此外, 由于可用的训练样本有限, 通常会出现欠样本训练而引发的过拟合问题, 在该方法中同时使用了丢弃函数(dropout)和整流线性函数(rectified linearunit, ReLU)以减缓过拟合。

-

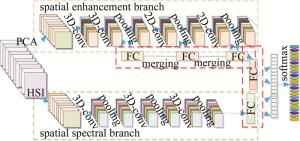

近年来,许多研究表明CNN对高光谱遥感图像分类提供了先进的结果[11-15]。由于高光谱图像(hyperspectral image, HSI)自身高维数性和数据量丰富的特性,它自身的空间和光谱特征信息对分类性能起了决定性作用[15]。CNN是目前在高光谱图像分类领域应用最广泛的深度学习网络[16]。参考文献[17]中利用3D-CNN对高光谱图像进行光谱-空间综合特征提取,且分类表现效果较佳。2D-CNN相比于3D-CNN参数较少,过拟合的风险较低,有研究表明,2D-CNN对高光谱图像的空间特征提取具有良好的性能[18]。CNN还具有局部连接和权重共享两大特点[19]。它只需要相邻层之间神经元的部分连接就可实现连通,同时也可以共享权重进而来减少训练参数[20]。本文中基于3D-CNN和2D-CNN研究高光谱分类方法,该方法结构如图 1所示。图中,FC是卷积神经网络结构中的全连接层(fully connected)。

如图 1所示,提出的框架使用双分支结构用于高光谱图像特征提取,主要包括3个部分: 第一部分是空间特征增强分支;第二部分是光谱-空间特征分支;第三部分是多尺度特征融合,最后使用softmax分类器以得到最终预测分类结果。

-

卷积层是CNN框架中至关重要的部分,通过计算输入数据和相应卷积核之间的点积之和来实现卷积操作,卷积层的每个通道可以表示为:

$ \boldsymbol{D}_{i}=\varOmega\left[\sum\limits_{j}\left(\boldsymbol{w}_{i} \cdot \boldsymbol{x}_{j}\right)+b_{i}\right] $

(1) 式中,Di是卷积特征图的第i个通道,wi代表第i个卷积核,bi是第i个特征图的偏置项,xj是先前层的第j个通道,操作符·代表的是2维卷积运算,Ω(·)代表的是非线性ReLU激活函数。Ω(·)可用来改善CNN的非线性并且加快网络模型的训练进程,它可以用如下公式表示:

$ \varOmega(x)=\left\{\begin{array}{l} x, (x>0) \\ 0, (x \leq 0) \end{array}\right. $

(2) 鉴于高光谱遥感图像空间分辨率不高且空间结构信息缺乏。在第1个分支中,将3D-CNN和2D-CNN结合作为空间特征提取的分支。首先,将原始高光谱数据进行降维,其次再进行切块划分操作。本文中使用的是主成分分析(principal component analysis, PCA)技术来实现降维。之后将切块得到的3维立方体输入到对应的卷积网络结构中,进行一系列相应的卷积和池化操作。在3D-CNN中,采用一层卷积、一层池化的架构。在该网络中的第i层、第j个特征图中位置为(x, y, z)神经元的连接值vij, xyz计算公式如下所示:

$ \begin{gathered} v_{i j, x y z}= \\ \varPhi\left(\sum\limits_{t} \sum\limits_{f=0}^{F_{i}-1} \sum\limits_{g=0}^{G_{i}-1} \sum\limits_{h=0}^{H_{i}-1} w_{i j t, f g h} \cdot v_{(i-1) t, (x+f, y+g, z+h)}+b_{i j}\right) \end{gathered} $

(3) 式中,Φ(·)是激活函数,Gi和Fi是卷积核空间维度尺寸的高和宽,Hi是卷积核的光谱维度尺寸, 是当前(第j个)特征图到第i-1层特征图的连接索引,wijt, fgh表示与第t个特征图的位置为(f, g, h)的连接值,v(i-1)t, (x+f, y+g, z+h)是i-1层第t个特征图在位置为(x+f, y+g, z+h)的值,bij是偏置值。

通过两层3维卷积对高光谱图像进行特征信息提取,已经提取到了光谱和空间特征,在此基础上再经过两层2维卷积进一步增强空间特征信息,将具有4层网络结构的混合CNN作为空间增强分支。在2D-CNN中,同时也采用一层卷积、一层池化的架构。在该网络中的第i层第j个特征图中位置为(x, y)的神经元vij, xy的连接值计算公式如下所示:

$ v_{i j, x y}=\varPhi\left(\sum\limits_{t} \sum\limits_{f=0}^{F_{i}-1} \sum\limits_{g=0}^{G_{i}-1} w_{i j t, f g} \cdot v_{(i-1) t, (x+f, y+g)}+b_{i j}\right) $

(4) 式中, wijt, fg表示与第t个特征图中的位置为(f, g)的连接值,v(i-1)t, (x+f, y+g)是i-1层第t个特征图在位置为(x+f, y+g)的值。

-

通常3D-CNN可以同时进行光谱和空间综合特征信息提取,且取得的分类性能显著,因此在该分支中,本方法使用具有3层结构的3D-CNN来提取光谱-空间特征。相比于较深层次的3D-CNN,3层结构能够更好地提取光谱-空间特征信息,并且也不会使得网络结构较复杂化。由于池化操作可以去除部分特征冗余信息,压缩特征图,使得网络结构复杂度缩减,参数量减少。为了尽可能地降低参数量,在本方法模型中使用的是池化操作中的一种最为常用的最大池化操作。通过最大池化可以减少特征图的尺寸和计算参数量,加快模型训练性能。

-

在传统的CNN中,全连接层通常被添加在池化层之后,在全连接层后面再使用softmax函数获得预测结果。但是忽略了各层之间的互补和强相关的空间和光谱特征,这将导致在卷积和池化过程中大量的信息特征丢失现象。基于该问题,本文中设计了一个多尺度特征融合策略,将浅层特征和深层特征进行结合确保了提取特征的完整性,使得输入分类器的特征具有多尺度特性,并减少池化过程中特征信息丢失的现象。与浅层特征相比,深层特征能够表示更抽象和复杂的结构信息,对于局部变化具有更强的鲁棒性[8]。最后,该框架结合使用了ReLU和dropout策略,有效缓解了过拟合问题并提高了该算法的泛化性能。将两个分支结合之后输入分类器中的多尺度特征可以表示如下:

$ \boldsymbol{I}=c\left(\left[v\left(\boldsymbol{L}_{1}, \boldsymbol{L}_{2}, \boldsymbol{L}_{3}\right)\right], \left[v\left(\boldsymbol{L}_{4}\right)\right]\right) $

(5) 式中, I代表的是整个框架的全连接层输出特征向量,L1,L2,L3代表的是第1个分支中的全连接层输出向量, L4代表的是第2个分支中的全连接层输出向量,v(x)代表的是add函数,c(x)代表的是concat函数。

在该方法中,将分别所得的增强空间信息和综合光谱-空间可分性信息进行特征融合后,之后通过softmax函数对输入的标签向量进行预测,该函数可以表示为:

$ p_{i}=\frac{\mathrm{e}^{\boldsymbol{u}_{i}}}{\sum\limits_{j=1}^{k} \mathrm{e}^{\boldsymbol{u}_{j}}} $

(6) 式中,pi是该标签向量属于第i类别的概率值,ui和uj表示在softmax层中输入样本的第i个和第j个类别,k代表地物种类数。

在该方法模型中,作者使用的是交叉熵损失函数。首先,通过它可以计算得到模型的预测标签和真实标签之间的差异大小。之后,为了优化网络权重再使用Adam优化器来实现,从而进一步使得网络模型达到最优值即损失函数趋于最小化的状态。该损失函数可表示:

$ L(x)=-\frac{1}{h} \sum\limits_{i=1}^{h}\left[y_{i} \ln \left(\hat{y}_{i}\right)+\left(1-y_{i}\right) \ln \left(1-\hat{y}_{i}\right)\right] $

(7) 式中,L(x)是损失函数,h代表训练样本数目,yi是真实标签值,$ {\hat y_i} $是模型输出的预测标签值。

-

实验平台的配置为Intel Core i7-8700k CPU 3.70GHz,32GB,GPU NVIDIA GeForce GTX 1070,基于Windows 10为操作系统,开发语言是基于Tensorflow后端的Keras库和Python。

-

本文中使用的数据集分别是Indian Pines和Pavia University。Indian Pines数据集中的图像尺寸为145×145,可用波段数量为200个,包含16种土地覆盖类别,具体的地物覆盖类别数量信息如表 1所示。Pavia University数据集中的图像尺寸为610×340,可用波段数量为103个,包含9种土地覆盖类别,具体的地物覆盖类别数量信息如表 2所示。

Table 1. Category information of Indian Pines

color name number color name number

— —

Oats 20

Alfalfa 46

Soybean-notill 972

Corn-notill 1428

Soybean-mintill 2455

Corn-mintill 830

Soybean-clean 593

Corn 237

Wheat 205

Grass-pasture 483

Woods 1265

Grass-trees 730

Buildings-Grass-Trees-Drives 386

Grass-pasture-mowed 28

Stone-Steel-Towers 93

Hay-windrowed 478 Table 2. Category information of Pavia University

color name number color name number

— —

Painted metal sheels 1122

Asphalt 5472

Bare Soil 4572

Meadows 13750

Bitumen 981

Gravel 1331

Self-Blocking Bricks 3363

Trees 2573

Shadows 776 -

实验中需要对原始高光谱图像进行数据预处理。首先,实验中采用的是PCA法来减少频谱冗余信息,在Indian Pines数据集中选取了30个主成分,在Pavia University数据集中选取了15个主成分。之后,将Indian Pines数据集进行切块处理,对于两个不同的数据集,作者采用相同的空间尺寸25作为3维立方体的空间尺寸输入。Indian Pines数据集中使用的3维数据立方体尺寸为25×25×30,Pavia University数据集中使用的3维数据立方体尺寸为25×25×15。此外,实验中的迭代训练次数设置为100,批次大小为128,学习率为0.001。之后再使用Adam优化器的反向传播算法通过softmax函数训练该模型。

在第1个分支中,它主要包括两个3-D卷积层和两个2-D卷积层。两个3-D卷积层的卷积核是(3, 3, 7)和(3, 3, 5),相对应的滤波器的数量是8, 16。两个2-D卷积层的卷积核是(3, 3)和(3, 3),采用的滤波器的数目都为64。在第2个分支中,使用3D-CNN来提取光谱和空间特征,该分支包含3个3维卷积层和3层池化层。这3个3-D卷积层的卷积内核分别是(3, 3, 7)和(3, 3, 5)和(3, 3, 3),相对应的滤波器的数目分别是8, 16和32。在这两个分支中,均采用的是最大池化,在3维卷积层之后的最大池化尺寸为(2, 2, 1),在2维卷积层之后的最大池化尺寸是(2, 2)。之后使用多尺度特征融合策略,将该双分支CNN得到的特征进行融合,可有效保证模型提取到特征的完整性。同时,ReLU和dropout的组合使用旨在缓解过度拟合的问题,有效提高了模型的鲁棒性和泛化性能。为了验证该算法的分类效果,实验中使用的训练样本数目占比为20%,测试样本数目占比为80%。实验中采用的评价指标分别是平均分类准确度(average accuracy, AA),kappa系数和整体分类准确度(overall accuracy, OA),在高光谱图像分类领域中,通常使用这些指标值的高低进行验证不同模型之间的性能差异。这些指标(AA,kappa,OA)的值越高,表明相对应算法模型的分类性能越有竞争优势。

表 3和表 4中分别给出了在不同数据集上不同方法得到的AA,kappa和OA的结果值。为了全面验证模型的性能,将该方法模型与未使用多尺度特征融合的方法(Proposed-1)支持向量机(support vector machine, SVM)[21],2D-CNN[18],3D-CNN[17],SSUN[8]等算法进行了对比。

Table 3. Classification evaluation index value(Indian Pines)

methods SVM 2D-CNN 3D-CNN SSUN Proposed-1 HY-CNN AA/% 83.15±1.1 82.70±1.0 89.07±0.6 97.12±0.1 98.93±0.1 99.24±0.1 kappa/% 84.27±0.45 85.01±1.6 93.09±0.3 97.52±0.1 98.96±0.1 99.35±0.1 OA/% 86.24±0.38 86.90±1.3 93.95±0.4 97.86±0.1 99.06±0.1 99.36±0.1 Table 4. Classification evaluation index value (Pavia University)

methods SVM 2D-CNN 3D-CNN SSUN Proposed-1 HY-CNN AA/% 93.60±0.14 95.10±0.1 96.54±0.5 99.90±0.0 99.75±0.1 99.91±0.03 kappa/% 93.63±0.17 96.04±0.3 97.10±0.3 99.72±0.1 99.80±0.05 99.90±0.05 OA/% 95.20±0.13 96.02±0.4 97.81±0.2 99.76±0.1 99.82±0.05 99.95±0.05 从表 3中的数据分析可知,在Indian Pines数据集上,该方法相比于SSUN而言具有很大的性能优势,3种评价指标OA,AA和kappa的值均增加了约2%;该方法相比于传统的神经网络2D-CNN和3D-CNN而言具有明显的性能优势,它能够更好地利用空间和光谱-空间信息;同时该方法相比于监督分类方法SVM而言也表现出了极大的竞争优势,分类性能有了明显的提升。从表 3可知,该方法的波动幅度相对较小,性能表现相对较稳定。由于使用了特征融合使得该方法能够捕捉细粒度的空间细节信息,降低了特征信息损失,因此使用多尺度特征融合策略的HY-CNN方法模型相比于不使用多尺度特征融合的方法模型(Proposed-1), 具有较好的性能。

从表 4中的数据分析可知,在Pavia University数据集中,该方法相比于传统的卷积网络3D-CNN而言,OA和kappa的值增加了约2%,AA的值增加了约3%。相比于2D-CNN,OA和kappa的值增加了约3%,AA的值增加了约4%。同时相比于先进的SSUN算法也表现出竞争优势,并且在该数据集上也表明了使用多尺度特征融合策略的HY-CNN方法具有性能优势且相对于其它方法性能较稳定。从表 3和表 4中的分类精度结果可知,在两个数据集上, 本文中提出的HY-CNN方法模型均进一步改善了高光谱图像的分类精度,并且也都表现出了较平稳的效果。

为了更加全面地验证HY-CNN方法的分类性能,在表 5中也给出了在不同数据集上该方法的空间增强分支和光谱-空间分支各自的分类结果,其中空间增强分支作为其第1个分支,光谱-空间分支作为其第2个分支。

Table 5. Classification evaluation index values of different sub-branch

Indian Pines Pavia University the first branch the second branch HY-CNN the first branch the second branch HY-CNN AA/% 97.82±0.4 97.76±0.6 99.24±0.1 99.34±0.2 99.46±0.1 99.91±0.03 kappa/% 98.27±0.2 98.33±0.2 99.35±0.1 99.46±0.2 99.56±0.1 99.90±0.05 OA/% 98.36±0.3 98.64±0.2 99.36±0.1 99.54±0.1 99.75±0.05 99.95±0.05 从表 5中的数据分析可知,在Indian Pines数据集中,HY-CNN方法与自身的空间增强分支和光谱-空间分支相比较而言,AA增加了约2%,kappa增加了约1%,OA增加了约1%。在Pavia University数据集中,HY-CNN方法与自身的空间增强分支和光谱-空间分支相比较而言,AA和kappa的两个评估指标增加了约0.5%,OA增加了约0.4%。同时在表 4中也给出了未使用多尺度特征融合的方法模型(Proposed-1)的分类结果,表 4和表 5中的数据均能够证明HY-CNN方法具有一定的分类性能优势。

传统的图像一般包含3个通道,高光谱遥感图像不同于传统的图像,具有丰富的光谱信息,波段数较多,且它存在“休斯现象”和“同物异谱”、“异物同谱”,容易受到外界复杂的空间分布和环境变化的影响,导致高光谱遥感图像的分类精度不理想。针对具有3维结构的高光谱遥感图像,将本文中的方法与一般的图像分类方法(ResNet50,DenseNet169等)进行了对比分析。表 6中给出了这两个方法在不同数据集上的AA,kappa和OA的结果值。可以看出: HY-CNN方法也表现出一定的性能优势。

Table 6. Comparative analysis of the results of different methods

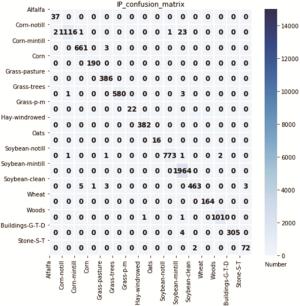

Indian Pines Pavia University ResNet50 DenseNet169 HY-CNN ResNet50 DenseNet169 HY-CNN AA/% 96.41±0.2 97.36±0.4 99.24±0.1 99.57±0.2 99.32±0.1 99.91±0.03 kappa/% 97.32±0.4 97.71±0.6 99.35±0.1 99.63±0.1 99.70±0.05 99.90±0.05 OA/% 97.56±0.4 97.62±0.2 99.36±0.1 99.65±0.1 99.75±0.1 99.95±0.05 图 2和图 3中分别给出了在Indian Pines和Pavia University两个数据集上实验所得到的混淆矩阵。

图 2和图 3中的右侧是一个色度带,每个类相应的样本数量用相对应的颜色显示。从图 2和图 3可以看出,使用HY-CNN方法模型在Indian Pines和Pavia University不同数据集上实验得到的混淆矩阵中误分类现象较少。通过以上混淆矩阵效果图可以直观看出该方法的分类性能,它的主对角线上的元素越多,表示该方法分类性能越好。同时,还可以便于分析每个类别中是否存在误分类现象以及相应不同地物类别的分类效果差异。

图 4和图 5分别是在两个不同数据集上(20%训练样本,80%测试样本)相应方法的分类可视化图(Indian Pines,Pavia University)。

从图 4c和图 5c可以看出,3D-CNN方法模型存在一些误分类问题,分类性能相对不佳。图 4d、图 4e和图 5d、图 5e相比于3D-CNN方法而言,性能有了极大提升,减少了一些误分类现象。由于使用了多尺度特征融合策略,使得提取到的特征具有更强的表示能力,因此,图 4e和图 5e相比于图 4d和图 5d而言,其分类性能有了进一步改善,且分类结果图具有较平滑和清晰的视觉效果。从图 4和图 5中的结果分析可知,该方法针对高光谱图像的分类表现结果具有竞争优势,在两个数据集上本文中所提出的HY-CNN方法显示出了先进的效果。

-

高光谱遥感图像自身数据维数较高,数据量丰富,它自身的空间特征和光谱特征信息对分类性能起了决定性作用。因此,提取高光谱遥感图像中的特征信息是提高分类性能的一个至关重要的步骤,本文中提出了一种基于混合CNN的高光谱遥感图像分类方法(HY-CNN)。首先,使用一个分支来提取光谱-空间特征,有效地利用光谱-空间信息;其次,由于高光谱图像的空间分辨率较低缺乏空间结构特征,另一个分支作为空间增强分支,使得提取到的特征信息具有更好地表示能力,有效地利用空间信息。再次,该方法中使用特征融合保证最终提取特征的完备性,它能够更好地捕捉特征细节信息,减少了信息损失;最后,在两个公开的高光谱遥感数据集上实验,实验结果表明,该方法相比较于传统的方法和一些先进的方法而言具有较好的分类性能。

混合卷积神经网络的高光谱图像分类方法

Hyperspectral image classification based on hybrid convolutional neural network

-

摘要: 为了解决高光谱图像领域中,传统卷积神经网络因部分特征信息损失而影响最终地物分类精度的问题,采用一种基于2维和3维的混合卷积神经网络的高光谱图像分类方法,从空间增强、光谱-空间两方面分别进行了特征提取。首先从空间增强角度提出一种3维-2维卷积神经网络混合结构,得到增强后的空间信息;其次从光谱-空间角度利用3维卷积网络结构,得到光谱-空间的综合可分性信息;最后将所得信息进行特征融合并分类。用该方法在两个数据集上进行了实验并与其它方法进行了对比。结果表明,该方法在Indian Pines与Pavia University数据集上分别取得了99.36%和99.95%的分类精度,其分类精度和kappa系数都优于其它方法。该方法对高光谱图像的分类表现出竞争优势。Abstract: The traditional convolutional neural network method can loss some feature information, which may lead to unsatisfied terrain classification accuracy in the field of hyperspectral. In order to solve the problem, a new hyperspectral images classification method based on the 2-D and the 3-D, named hybrid convolutional neural network, was proposed. This method mainly extracted features from the spatial enhancement aspect and the spectral-spatial aspect. Firstly, a 3-D-2-D convolutional neural network hybrid structure was proposed for enhance spatial information. Secondly, the 3-D convolutional neural network structure was used for joint feature extraction from the aspect of spectral-spatial, and then the spectral-spatial comprehensive separability information was obtained. Finally, the separately obtained information was feature fused and classified. This method was used for classification experiments on hyperspectral data sets and compared with other methods. The results show that the classification accuracy of this method is 99.36% and 99.95% respectively in Indian Pines and Pavia University data set, and its classification accuracy and kappa coefficient are also better than other methods. This method has a competitive advantage in the classification of hyperspectral images.

-

Table 1. Category information of Indian Pines

color name number color name number

— —

Oats 20

Alfalfa 46

Soybean-notill 972

Corn-notill 1428

Soybean-mintill 2455

Corn-mintill 830

Soybean-clean 593

Corn 237

Wheat 205

Grass-pasture 483

Woods 1265

Grass-trees 730

Buildings-Grass-Trees-Drives 386

Grass-pasture-mowed 28

Stone-Steel-Towers 93

Hay-windrowed 478 Table 2. Category information of Pavia University

color name number color name number

— —

Painted metal sheels 1122

Asphalt 5472

Bare Soil 4572

Meadows 13750

Bitumen 981

Gravel 1331

Self-Blocking Bricks 3363

Trees 2573

Shadows 776 Table 3. Classification evaluation index value(Indian Pines)

methods SVM 2D-CNN 3D-CNN SSUN Proposed-1 HY-CNN AA/% 83.15±1.1 82.70±1.0 89.07±0.6 97.12±0.1 98.93±0.1 99.24±0.1 kappa/% 84.27±0.45 85.01±1.6 93.09±0.3 97.52±0.1 98.96±0.1 99.35±0.1 OA/% 86.24±0.38 86.90±1.3 93.95±0.4 97.86±0.1 99.06±0.1 99.36±0.1 Table 4. Classification evaluation index value (Pavia University)

methods SVM 2D-CNN 3D-CNN SSUN Proposed-1 HY-CNN AA/% 93.60±0.14 95.10±0.1 96.54±0.5 99.90±0.0 99.75±0.1 99.91±0.03 kappa/% 93.63±0.17 96.04±0.3 97.10±0.3 99.72±0.1 99.80±0.05 99.90±0.05 OA/% 95.20±0.13 96.02±0.4 97.81±0.2 99.76±0.1 99.82±0.05 99.95±0.05 Table 5. Classification evaluation index values of different sub-branch

Indian Pines Pavia University the first branch the second branch HY-CNN the first branch the second branch HY-CNN AA/% 97.82±0.4 97.76±0.6 99.24±0.1 99.34±0.2 99.46±0.1 99.91±0.03 kappa/% 98.27±0.2 98.33±0.2 99.35±0.1 99.46±0.2 99.56±0.1 99.90±0.05 OA/% 98.36±0.3 98.64±0.2 99.36±0.1 99.54±0.1 99.75±0.05 99.95±0.05 Table 6. Comparative analysis of the results of different methods

Indian Pines Pavia University ResNet50 DenseNet169 HY-CNN ResNet50 DenseNet169 HY-CNN AA/% 96.41±0.2 97.36±0.4 99.24±0.1 99.57±0.2 99.32±0.1 99.91±0.03 kappa/% 97.32±0.4 97.71±0.6 99.35±0.1 99.63±0.1 99.70±0.05 99.90±0.05 OA/% 97.56±0.4 97.62±0.2 99.36±0.1 99.65±0.1 99.75±0.1 99.95±0.05 -

[1] LI X, DING M L, PIŽURICA A. Deep feature fusion via two-stream convolutional neural network for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(4): 2615-2629. doi: 10.1109/TGRS.2019.2952758 [2] GUO H, LIU J, XIAO Z, et al. Deep CNN-based hyperspectral image classification using discriminative multiple spatial-spectral feature fusion[J]. Remote Sensing Letters, 2020, 11(9): 827-836. doi: 10.1080/2150704X.2020.1779374 [3] ZHAO W Zh, DU Sh H. Spectral-spatial feature extraction for hyperspectral image classification: A dimension reduction and deep learning approach[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(8): 4544-4554. doi: 10.1109/TGRS.2016.2543748 [4] CHEN Y Sh, LIN Zh H, ZHAO X, et al. Deep learning-based classification of hyperspectral data[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote, 2014, 7(6): 2094-2107. doi: 10.1109/JSTARS.2014.2329330 [5] LIU P, CHOO K K R, WANG L, et al. SVM or deep learning? A comparative study on remote sensing image classification[J]. Soft Computing, 2017, 21(23): 7053-7065. doi: 10.1007/s00500-016-2247-2 [6] ZHONG P, GONG Zh Q, LI Sh T, et al. Learning to diversify deep belief networks for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(6): 3516-3530. doi: 10.1109/TGRS.2017.2675902 [7] ZHANG M M, LI W, DU Q. Diverse region-based CNN for hyperspectral image classification[J]. IEEE Transactions on Image Processing, 2018, 27(6): 2623-2634. doi: 10.1109/TIP.2018.2809606 [8] XU Y H, ZHANG L P, DU B, et al. Spectral-spatial unified networks for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(10): 5893-5909. [9] PAOLETTI M E, HAUT J M, FERNANDEZ-BELTRAN R, et al. Capsule networks for hyperspectral image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(4): 2145-2160. doi: 10.1109/TGRS.2018.2871782 [10] ZHANG H K, LI Y, ZHANG Y Zh, et al. Spectral-spatial classification of hyperspectral imagery using a dual-channel convolutional neural network[J]. Remote Sensing Letters, 2017, 8(5): 438-447. doi: 10.1080/2150704X.2017.1280200 [11] ZHONG Z L, LI J, LUO Zh M, et al. Spectral-spatial residual network for hyperspectral image classification: A 3-D deep learning framework[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(2): 847-858. doi: 10.1109/TGRS.2017.2755542 [12] LI J Y, LIANG B X, WANG Y H. A hybrid neural network for hyperspectral image classification[J]. Remote Sensing Letters, 2020, 11(1): 96-105. doi: 10.1080/2150704X.2019.1686780 [13] LI W, WU G D, ZHANG F, et al. Hyperspectral image classification using deep pixel-pair features[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(2): 844-853. doi: 10.1109/TGRS.2016.2616355 [14] CHEN Y Sh, JIANG H L, LI Ch Y, et al. Deep feature extraction and classification of hyperspectral images based on convolutional neural networks[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(10): 6232-6251. doi: 10.1109/TGRS.2016.2584107 [15] ROY S K, KRISHNA G, DUBEY S R, et al. HybridSN: Exploring 3-D-2-D CNN feature hierarchy for hyperspectral image classification[J]. IEEE Geoscience and Remote Sensing Letters, 2020, 17(2): 277-281. doi: 10.1109/LGRS.2019.2918719 [16] GUAN Sh H, YANG G, LI H, et al. Hyperspectral image classification based on 3-D convolutional recurrent neural network[J]. Laser Technology, 2020, 44(4): 485-491(in Chinese). [17] LI Y, ZHANG H K, SHEN Q. Spectral-spatial classification of hyperspectral imagery with 3-D convolutional neural network[J]. Remote Sensing, 2017, 9(1), 67. doi: 10.3390/rs9010067 [18] MAKANTASIS K, KARANTZALOS K, DOULAMIS A, et al. Deep supervised learning for hyperspectral data classification through convolutional neural networks[C]//2015 IEEE International Geoscience and Remote Sensing Symposium (IGARSS). New York, USA: IEEE, 2015: 4959-4962. [19] HANG R L, LI Zh, GHAMISI P, et al. Classification of hyperspectral and LiDAR data using coupled CNNs[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(7): 4939-4950. doi: 10.1109/TGRS.2020.2969024 [20] HE M Y, LI B, CHEN H H. Multi-scale 3-D deep convolutional neural network for hyperspectral image classification[C]// 2017 IEEE International Conference on Image Processing (ICIP). New York, USA: IEEE, 2017: 3904-3908. [21] MELGANI F, BRUZZONE L. Classification of hyperspectral remote sensing images with support vector machines[J]. IEEE Transactions on Geoscience and Remote Sensing, 2004, 42(8): 1778-1790. doi: 10.1109/TGRS.2004.831865 -

网站地图

网站地图

下载:

下载: